Por medio de un algoritmo computacional, un equipo de investigadores de la Universidad de Guadalajara (UDG) desarrolló una red neuronal que permite que un pequeño robot detecte diferentes patrones, como imágenes, huellas digitales, caligrafía, rostros, cuerpos, frecuencias de voz y secuencias de ADN.

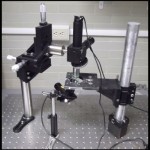

Nancy Guadalupe Arana Daniel, científica del Centro Universitario de Ciencias Exactas e Ingenierías (CUCEI) de la UDG, se enfocó en el reconocimiento de siluetas humanas en situaciones de desastre. Con ese propósito diseñó un sistema en que un robot, provisto de una lámpara portátil y una cámara estereoscópica, obtiene las imágenes del entorno y tras una serie de operaciones matemáticas se distinguirá entre personas y escombros.

Durante el proceso de captación de imágenes se utilizan cámaras de alta definición para escanear el ambiente, posteriormente se limpia la imagen y se segmentan los patrones de interés, en este caso las siluetas humanas de los escombros.

Debido a la complejidad, este proyecto interdisciplinario requirió del apoyo de los doctores Alma Yolanda Alanis García, Carlos Alberto López Franco y el M.C. Gehová López también del CUCEI, quienes se encargaron del control visual y del movimiento del robot, el cual tiene un aspecto similar al de las películas animadas, en forma de trapecio, con un sistema de tracción y fricción a base de orugas (como la de los tanques de guerra), ideal para todo tipo de terrenos.

Estas características son necesarias para abrirse paso en relieves irregulares; además cuenta con sensores de movimiento, cámaras, láser, infrarrojo, que le permiten reconstruir el ambiente, y de ese modo encontrar caminos o crear mapas en 2D.

Inicialmente todo el sistema viene integrado en el robot, pero cuando este modelo es demasiado frágil para cargar la computadora, el algoritmo se corre en una laptop aparte, desde donde se controla el robot vía wifi. De ese mismo modo las imágenes de reconocimiento humano obtenidas por las cámaras del robot son transmitidas a la computadora, comentó Arana Daniel.

Una vez que el robot obtiene las siluetas, recurre al uso del sistema descriptor, que obtiene las características visuales (puntos en 3D) para segmentar (envolver en círculos los objetos) y luego construir las siluetas externas humanas. Dichas siluetas servirán como descriptores para entrenar una red neuronal llamada CSVM, desarrollada por la doctora. Arana Daniel, para reconocer patrones

Después trasforma las imágenes capturadas en valores numéricos que representan la forma, color y densidad. Estas cifras al ser unidas dan origen a una nueva imagen, que tras pasar por un filtro detectará si se trata de una silueta humana o no.

“El reconocimiento de patrones sirve para que los descriptores de manera automática distingan los objetos que contienen información de las características que representan una silueta humana; ello implica desarrollar algoritmos que resuelven problemas tanto de armado del descriptor del objeto como de asignación de clases a dicho objeto”, explicó la investigadora de la UDG, especialista en patrones de reconocimiento.

Finalmente, el propósito es seguir trabajando con el robot y entrenarlo para que de manera automática clasifique las formas humanas a raíz de la experiencia previa. La idea es que imiten el proceso de aprendizaje de los seres inteligentes y relacionen los elementos de manera automática.