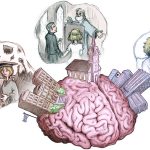

Los cambios en la entonación son fundamentales para el éxito de la comunicación humana. En las lenguas tonales, como el chino mandarín, la alteración del tono llega a cambiar por completo el significado de una palabra. Y en idiomas como el inglés o el español esta variación puede modificar el sentido de una frase.

Aunque está demostrado que ciertas partes del cerebro humano y de otros primates son sensibles al tono vocal y al modo de hablar, ningún estudio ha descubierto el misterio sobre cómo se detectan y se representan esos cambios en el cerebro.

"Una de nuestras misiones es entender de qué manera el cerebro traduce los sonidos en significado", explica Claire Tang

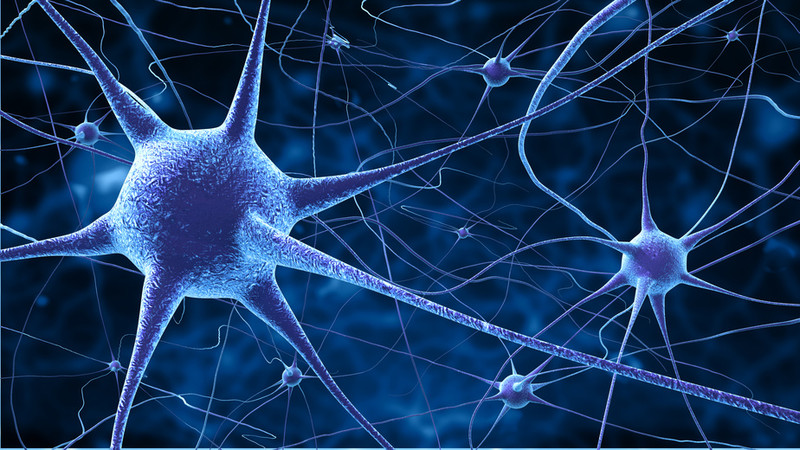

Ahora, científicos de la Universidad de California en San Francisco (EE UU) han identificado un grupo concreto de neuronas en el cerebro que crean diferentes respuestas a las modificaciones en el tono del lenguaje.

“Una de las misiones del laboratorio es entender de qué manera el cerebro traduce los sonidos en significado”, asegura Claire Tang, coautora del trabajo que se publica esta semana en Science. “Lo que estamos observando es que hay neuronas en el neocortex cerebral que procesan no solo qué palabras estamos diciendo, sino también cómo son dichas”, explica.

Tang y su equipo monitorizaron la actividad eléctrica de las neuronas en una parte de la corteza auditiva, el giro temporal superior (STG, por sus siglas en inglés), donde ya se habían observado indicios del procesamiento del acento, los tonos y la entonación.

Así, analizaron la respuesta de las neuronas ante cuatro frases grabadas por tres voces diferentes y con distintas entonaciones: neutral, enfatizando la primera palabra, enfatizando la tercera, o en modo pregunta.

Neuronas que se activan en función del énfasis de la frase

Los resultados demostraron que algunas neuronas del STG pueden distinguir las voces debido a las diferencias en la gama vocal. Otras neuronas distinguen cada una de las frases, sin importar quién lo diga, basándose en los distintos fonemas que las forman. Y un último grupo hace distinciones entre los cuatro patrones de entonación usados, de modo que modifican su actividad dependiendo de donde recaiga el énfasis, sin importar la frase o la persona que las pronuncie.

A partir de esta información, los científicos crearon un algoritmo para predecir la reacción de las neuronas en función del hablante, la fonética y la entonación, y trataron de deducir las respuestas ante cientos de frases pronunciadas por diferentes personas.

Las neuronas que responden a la entonación se centran en cómo varía el tono a cada instante

De este modo, observaron que las neuronas que responden a la entonación se centran más en el tono relativo alto y bajo de la voz, es decir, cómo varía la entonación a cada instante del discurso. Por el contrario, aquellas neuronas que responden ante los distintos hablantes se enfocan más en el tono absoluto (capacidad de distinguir una nota sin la ayuda de otra referencial).

“Para mí este es uno de los aspectos más emocionantes del estudio”, asegura Tang. “Hemos sido capaces de demostrar no solo dónde se codifica la prosodia si no cómo, al explicar la actividad en términos de cambios específicos en el tono vocal”.

El estudio, que se pudo llevar a cabo gracias a una tecnología para mapear la actividad eléctrica en pacientes con epilepsia severa antes de la cirugía, sostiene una vez más que el cerebro es capaz de identificar características importantes que dan significado a lo que está escuchando. Pero más importante aún, revela cómo el cerebro es capaz de desmontar la compleja fuente de sonidos del habla que recibe en cuestión de milisegundos (entonación, consonantes y vocales que forman palabra y frases, etc.).

“Ahora, la pregunta importante sin contestar es cómo controla el cerebro nuestro tracto vocal para producir esos sonidos intencionales. Espero que resolvamos este misterio pronto”, concluye Tang.

Referencia bibliográfica:

C. Tang et al. «Intonational speech prosody encoding in the human auditory cortex». Science, 24 de agosto de 2017. http://science.sciencemag.org/cgi/doi/10.1126/science.aam8577