La conectividad es algo que damos por hecho en nuestra vida diaria, una realidad de la que casi no podemos prescindir, pero también una realidad de la que muchos no somos conscientes de su verdadera magnitud y de la tremenda complejidad que oculta.

Una red de telecomunicación está formada por múltiples equipos y enlaces que conectan a los usuarios con los servicios (conmutadores, enrutadores, líneas de comunicación, antenas, equipos en casa del cliente, etc.), mucha tecnología que en definitiva se materializa fundamentalmente en infraestructura de propósito muy específico. Una red de comunicación es por tanto una infraestructura compleja, heterogénea, bastante rígida y en la que cualquier cambio que se quiera introducir implica largos periodos de tiempo, de hasta decenas de años, en los que hay que involucrar a los múltiples agentes que intervienen en su construcción.

La industria proveedora de equipos, hasta ahora, se ha centrado en el desarrollo de equipamiento de comunicaciones especializado en realizar funciones concretas y no intercambiables, con un hardware específicamente diseñado para ello, lo que ha favorecido un modelo en el que las tecnologías proporcionadas por diferentes suministradores, son exclusivas, y difícilmente interconectables con las de otros proveedores. Si a esto se le añade el incesante avance de la tecnología, el resultado es que las inversiones necesarias para mantener y modernizar una red son muy elevadas, por lo que cualquier cambio tecnológico tiene que estar muy justificado, y se acomete de forma gradual. El resultado final es que en las redes acaban coexistiendo, a la fuerza, un número elevado de diferentes tecnologías. Toda esta complejidad dificulta además enormemente la operación y hace que la red sea inflexible y que no pueda adaptarse a cambios no previstos con mucha antelación, y en muchos casos la propia red acaba actuando de freno a la innovación en servicios para los clientes finales.

Este escenario ha provocado que las operadoras de telecomunicación se hayan puesto como objetivo el transformar la red en una infraestructura mucho más eficiente, mucho más flexible, moldeable e inteligente, que le permita competir de forma ágil y eficaz en un mundo cada vez más digital. Para conseguir este objetivo se plantean cambios en la arquitectura de la red, en las infraestructuras que soportan los equipos, en la centralización-

¿EN QUÉ CONSISTE LA VIRTUALIZACIÓN DE RED?

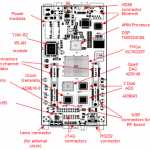

Por un lado, en separar el software del hardware, haciendo que las funciones de red se basen, lo más posible, en software y puedan llevarse a equipos hardware de propósito general (ej. servidores de gama alta). De esta manera, se conseguirá que la misma infraestructura pueda ser utilizada para diferentes propósitos, lo que abaratará el coste y facilitará la realización de cambios en la red. Esto es lo que se conoce como “Virtualización de Funciones de Red” (NFV según las siglas en inglés de Network Functions Virtualisation). El principal reto en esta área es conseguir que equipos de propósito general proporcionen rendimientos similares a los de los equipos con hardware específico.

Por otro lado, en conseguir que la coordinación y gestión de esta infraestructura se haga de forma automatizada, y lo más independientemente posible de dicha infraestructura, gracias al uso de interfaces estándares y de software que permita controlar completamente la infraestructura de manera externa a la misma, consiguiendo así un comportamiento de la red más sencillo y coherente. Esto es lo que se conoce como “Redes Definidas por Software” (Software Defined Networking).

En el siguiente vídeo se muestra de manera gráfica una explicación de todos estos conceptos:http://youtu.be/js7FgbubLRk

¿Y QUÉ ESTÁN HACIENDO LAS OPERADORAS?

Todas las operadoras de telecomunicación son conscientes del punto de inflexión en el que se encuentran y de la necesidad de innovar en sus modelos y arquitecturas de red y en la manera en la que se operan las infraestructuras de telecomunicación para asegurar su sostenibilidad. Y por supuesto, están trabajando en ello a través de numerosas pruebas de concepto y pilotos, y a través de foros de estandarización, donde quizás el más relevante es el ETSI NFV ISG (Network Functions Virtualisation Industry Standardization Group). Este foro fue creado a comienzos de 2013 y Telefónica es uno de los miembros fundadores.

El objetivo ahora es impulsar la tecnología y hacerla llegar a las redes lo antes posible. Por ello Telefónica está trabajando en este concepto a través de su Laboratorio de Referencia NFV, ayudando al ecosistema de suministradores de soluciones de red a probar y desarrollar funciones de red virtualizadas junto con las capas superiores de gestión y orquestación. Nuestro objetivo es promover la interoperabilidad y proporcionar un ecosistema más abierto de forma que los proveedores de servicios de telecomunicación adapten y amplíen sus servicios de una manera más sencilla.

Sin duda, evolucionar hacia un modelo NFV es un proceso a largo plazo. Del mismo modo que la evolución a las redes de paquetes comenzó en los años 90 y todavía estamos en ello (hasta que no apaguemos todo el “legado” (el legacy) -la PSTN- nuestras redes no serán todo IP), la evolución de la tecnología NFV, que comenzó en 2012, también habrá de ir calando poco a poco en los diferentes segmentos que constituyen la red.

La carrera hacia la virtualización de red es una carrera de fondo, no una carrera de velocidad. Y en esta carrera habrá que pasar por muchos estadios. De momento, todo el ecosistema de suministradores ha adoptado este nuevo paradigma y está en movimiento. Los diferentes foros de estandarización trabajan en la implicación que NFV tendrá en su ámbito de actuación. Los fabricantes presentan sus aproximaciones y realizan pruebas de concepto. Las operadoras demandan una oferta abierta, multi-suministrador y que se adapte a sus necesidades. Al tiempo, nuevos agentes del mundo IT se aproximan al mundo de la red con su experiencia en el ámbito de “la nube” (el cloud). Nuevos entrantes y start-ups ven posible entrar a formar parte de una propuesta de valor nueva. Y mientras, la virtualización sigue el proceso natural de cualquier ciclo de maduración tecnológica.

Nos encontramos en las primeras fases. De momento, ya se ha demostrado que técnicamente es posible virtualizar muchas funciones de red y muchas operadoras y suministradores están presentando sus resultados y lecciones aprendidas. La situación actual, más allá de las pruebas de concepto y pilotos, muestra ejemplos de operadoras que han introducido ya equipamiento de propósito general en la red y que lo han incorporado en su negocio.

Evidentemente, hay que seguir trabajando para que la tecnología continúe su evolución y sigamos aprendiendo cómo sacarle el mayor partido a la misma. Los retos son muchos. Pero lo conseguido hasta ahora también es mucho. Es el cauce habitual que sigue toda innovación que llegue a ver el mercado y tener éxito, un camino de compromiso, esfuerzo y confianza en obtener los resultados. No puede ser de otro modo, no hay atajos.

(Antonio José Elizondo Armengol/IMDEA Networks Institute)